机器视觉

功能测试

shell

网络运维

云编程

进程

位置编码

大学生心理健康咨询系统

医学

工企专利匹配

远程医疗

技术

百元百鸡

选择器优先级

数据驱动

次世代建模

taro

shellcode

Go语言

snowflake

softmax

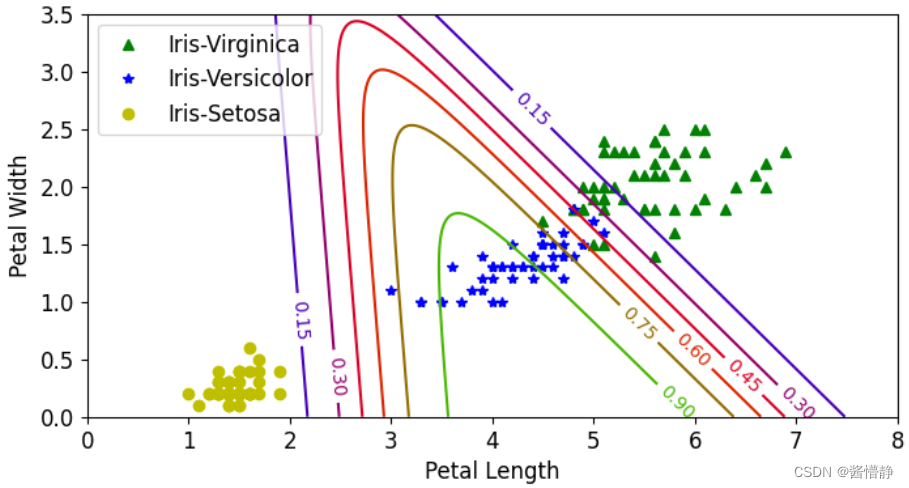

2024/4/11 20:10:08【机器学习】逻辑回归(实战)

逻辑回归(实战) 目录一、准备工作(设置 jupyter notebook 中的字体大小样式等)二、绘制 sigmoid 函数:σ(z)11e−z\sigma(z)\frac{1}{1e^{-z}}σ(z)1e−z1三、查看鸢尾花数据集1、加载 iris 数据集并查看2、设计二分…

softmax之温度系数

1.数学表示

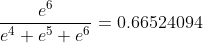

这是传统的softmax: q i e x p ( z i ) ∑ j e x p ( z j ) q_i \frac{exp(z_i)}{\sum_jexp(z_j)} qi∑jexp(zj)exp(zi) 或者写: q i e x p ( z i ) / 1.0 ∑ j e x p ( z j / 1.0 ) q_i \frac{exp(z_i)/1.0}{\sum_jexp(z_j/…

softmax梯度矩阵向量化实现推导

前言

前面的SVM梯度矩阵向量化实现,其实不能算是推导出来的,应该算是“凑出来的”,由结果推过程,今天又遇到了softmax的梯度矩阵,我觉得不能再逃避了,思考了很久,终于算真正地把这个搞明白

预…

关于softmax,cross entropy,三层全连接的导数计算以及反向传播

在本文中,我们主要介绍softmax,softmaxcrossentropy,三层全连接的导数计算和反向传播

softmax

定义:S(ai)eai∑j1NeajS(a_i) \frac{e^{a_i}}{\sum_{j1}^N{e^{a_j}}}S(ai)∑j1Neajeai倒数计算过程(令SiS_i…

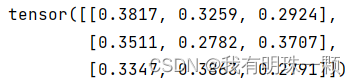

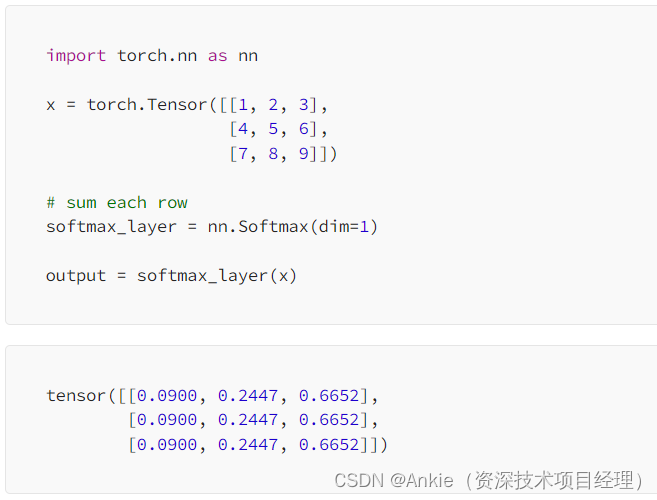

Pytorch nn.Softmax(dim=?) 详解

本文参考自:Pytorch nn.Softmax(dim?) - 知乎

原文写得很好了,我这边另外完善了一些细节,让大家理解地更加直白一些。

可以先去看上面的参考文章,也可以直接看我这篇。 目录

1、tensor1

1)已知该矩阵的维度为&am…

利用微调的deberta-v3-large来预测情感分类

前言:

昨天我们讲述了怎么利用emotion数据集进行deberta-v3-large大模型的微调,那今天我们就来输入一些数据来测试一下,看看模型的准确率,为了方便起见,我直接用测试集的前十条数据

代码:

from transfor…

深度学习入门——softmax函数实现

在分类问题中经常使用softmax函数:

分子:输入信号ak的指数函数分母:所有输入信号的指数函数和 由上图可得,softmax函数的输出层的各个神经元都受到所有输入信号的影响

1. softmax函数的实现

# 神经网络的多元分类利用到softma…

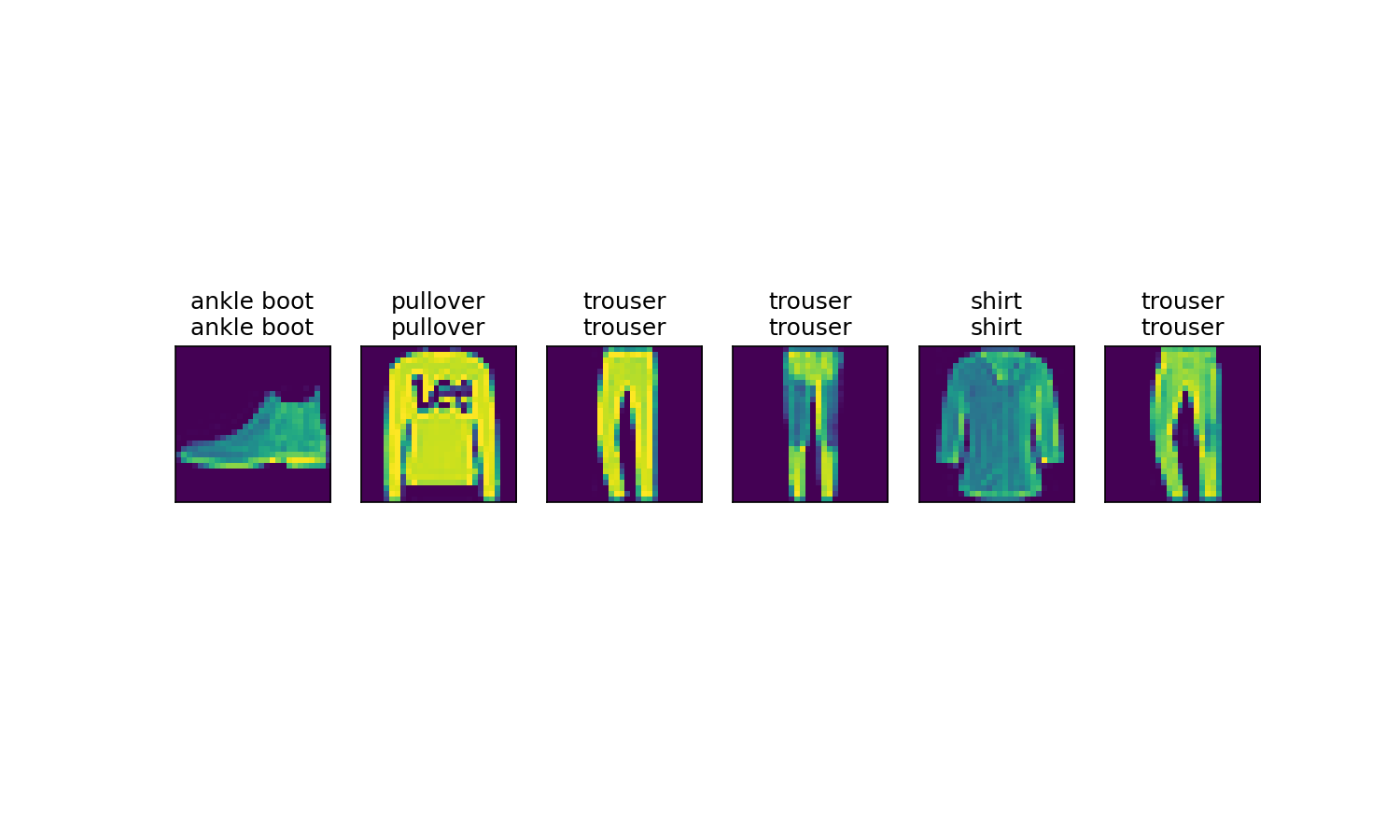

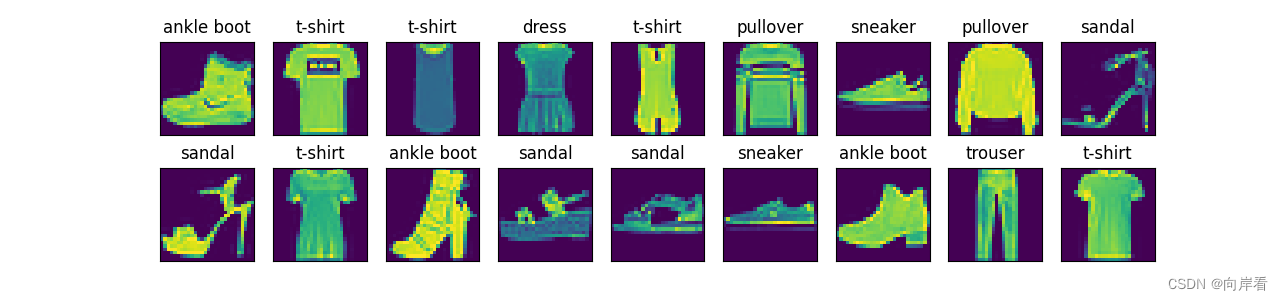

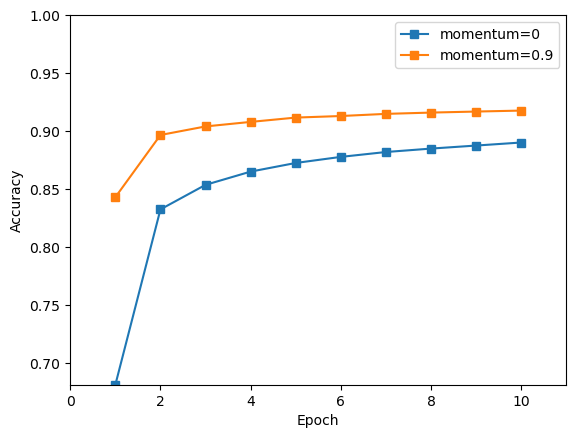

【动手学深度学习】softmax回归的从零开始实现(PyTorch版本)(含源代码)

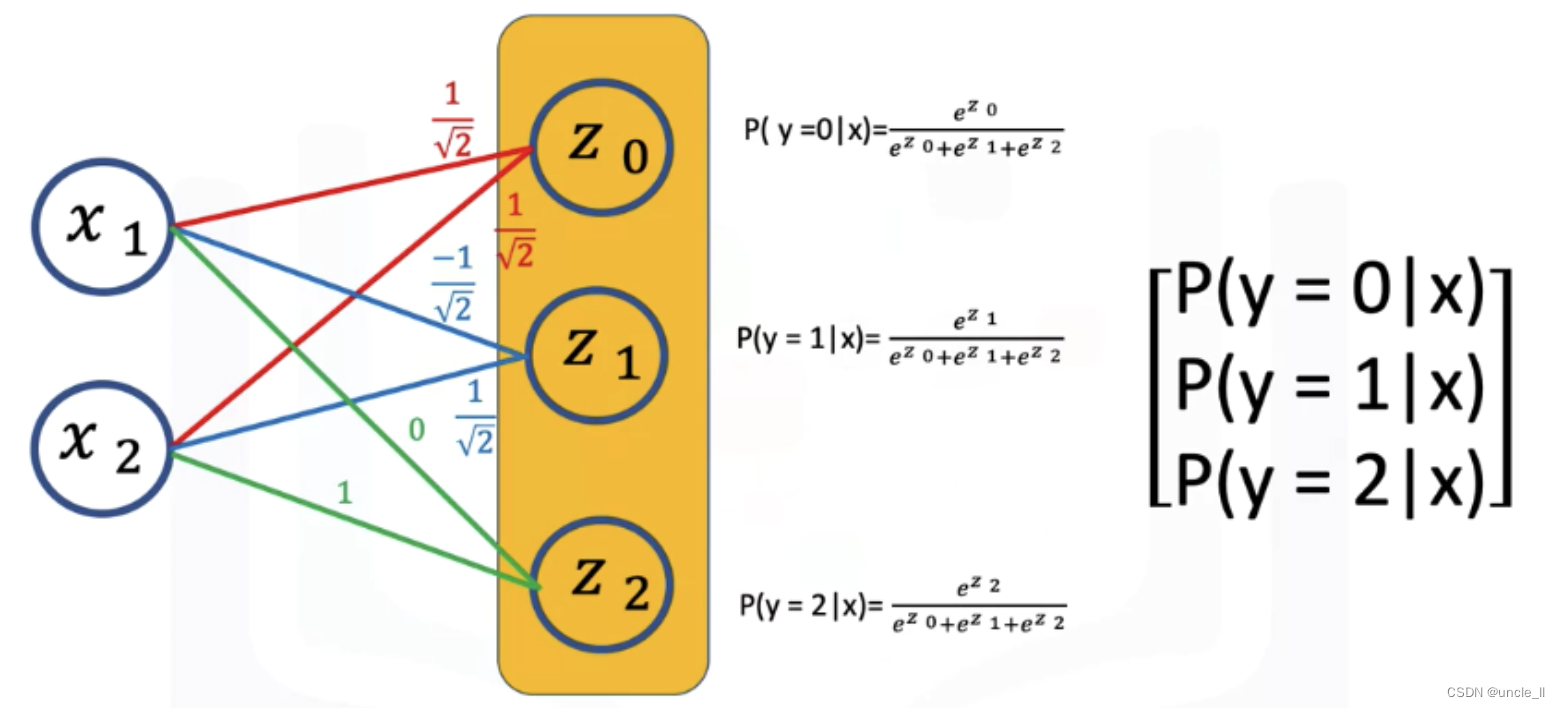

目录:softmax回归的从零开始实现一、理论基础1.1 前言1.2 分类问题1.3 网络架构1.4 全连接层的参数开销1.5 softmax运算1.6 小批量样本的矢量化1.7 损失函数1.7.1 对数似然1.7.2 softmax及其导数1.7.3 交叉熵损失1.8 信息论基础1.8.1 熵1.8.2 信息量1.8.3 重新审视交…

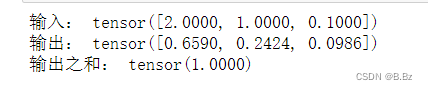

Transformer模型-softmax的简明介绍

今天介绍transformer模型的softmax softmax的定义和目的:

softmax:常用于神经网络的输出层,以将原始的输出值转化为概率分布,从而使得每个类别的概率值在0到1之间,并且所有类别的概率之和为1。这使得Softmax函数特别适…

从线性回归(Linear regression)到逻辑回归(Logistic regression)

今天我想要重新对线性回归和逻辑回归做一个总结回顾,相比于简单的调用接口,我希望自己可以更深入的理解本质。只有对算法有了好的理解,再加上数据才能做有意义的事情: 线性回归逻辑回归 线性回归

什么叫做线性回归?就…

PyTorch----Softmax函数与交叉熵函数

二分类问题和多分类问题

二分类问题: 分类任务中有两个类别。比如前面感知机识别香蕉还是苹果,一般会训练一个分类器,输入一幅图像,输出该图像是苹果的概率为p,对p进行四舍五入,输出结果为0或者1ÿ…

【机器学习】Softmax推导

LR可以看成是Softmax的特例。 LR主要是用于二分类,如果面临的是多分类问题,可以用Softmax。Softmax通常也是深度学习图像识别网络的最后一层。 在LR中,参数 θ是一个向量,而在Softmax中,参数可以看成是一个矩阵。也就是…

记一次d2l_softmax回归中的错误

错误代码与现象分析

def train_epoch_ch3(net, train_iter, loss, updater): #save"""训练模型一个迭代周期"""# 将模型设置为训练模式if isinstance(net, torch.nn.Module):net.train()# 训练损失总和、训练准确度总和、样本数metric Accumul…

交叉熵损失函数求导与Softmax函数求导

交叉熵损失函数求导与Softmax函数求导 前情提要 交叉熵损失函数 对Softmax函数求导 对交叉熵损失函数求导 前情提要 在做单分类的时候,一般模型的最后一层是线性层Linear做分类器,输出在每个标签上的logits。损失函数为交叉熵损失函数,会…

动手学深度学习(三)线性神经网络—softmax回归

分类任务是对离散变量预测,通过比较分类的概率来判断预测的结果。 softmax回归和线性回归一样也是将输入特征与权重做线性叠加,但是softmax回归的输出值个数等于标签中的类别数,这样就可以用于预测分类问题。 分类问题和线性回归的区别&#…

计算机视觉与深度学习-全连接神经网络-激活函数- [北邮鲁鹏]

文章目录 基础知识为什么需要非线性操作(激活函数)?激活函数 vs 数据预处理常用的激活函数Sigmoid函数 (Logistic函数)双曲正切函数(Tanh函数)线性整流函数(ReLU函数)Lea…

A.深度学习基础入门篇[四]:激活函数介绍:tanh、sigmoid、ReLU、PReLU、ELU、softplus、softmax、swish等

1.激活函数 激活函数是人工神经网络的一个极其重要的特征; 激活函数决定一个神经元是否应该被激活,激活代表神经元接收的信息与给定的信息有关; 激活函数对输入信息进行非线性变换,然后将变换后的输出信息作为输入信息传给下一层…

一文详解Softmax的性质与Self-Attention初步解析

概述

最近研究超平面排列(Hyperplane Arrangement)问题的时候,发现ReLU有其缺陷,即举例来说,ReLU 无法使用单一的超平面将分离的所有数据,完整的输出,即只会输出半个空间映射的数据,而另一半空间的数据被置…

深度学习与计算机视觉[CS231N] 学习笔记(3.2):Softmax Classifier(Loss Function)

在数学,尤其是概率论和相关领域中,Softmax函数,或称归一化指数函数,是逻辑函数的一种推广。它能将一个含任意实数的K维的向量z“压缩”到另一个K维实向量α(z)中,使得每一个元素的范围都在(0,1)}之间,并且所…

一篇文章彻底搞懂熵、信息熵、KL散度、交叉熵、Softmax和交叉熵损失函数

文章目录 一、熵和信息熵1.1 概念1.2 信息熵公式 二、KL散度和交叉熵2.1 KL散度(相对熵)2.2 交叉熵 三、Softmax和交叉熵损失函数3.1 Softmax3.2 交叉熵损失函数 一、熵和信息熵

1.1 概念 1. 熵是一个物理学概念,它表示一个系统的不确定性程度,或者说是…

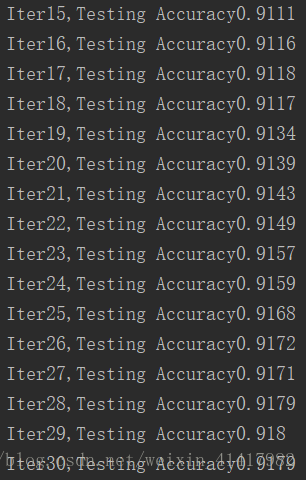

【深度学习】Softmax实现手写数字识别

实训1:Softmax实现手写数字识别

相关知识点: numpy科学计算包,如向量化操作,广播机制等

1 任务目标

1.1 简介

本次案例中,你需要用python实现Softmax回归方法,用于MNIST手写数字数据集分类任务。你需要完成前向计算…

全连接层解决MNIST

Tensorflow

一开始呢,让我们先了解一下tensorflow的运行方式。简单来说,我们使用步骤一共有三个:创建图,运行图,保存图。 Tensorflow的计算是在图(graph)里面计算的,因此我们必须按照自己的需求来设计一张…

Softmax函数解析:从入门到高级

Softmax函数解析:从入门到高级

大家好,我是免费搭建查券返利机器人赚佣金就用微赚淘客系统3.0的小编,也是冬天不穿秋裤,天冷也要风度的程序猿!在编程的世界里,有许多神奇的函数和算法,今天我们…

softmax中axis参数

从caffe中我们看到softmax有下面这些参数

// Message that stores parameters used by SoftmaxLayer, SoftmaxWithLossLayer

message SoftmaxParameter {enum Engine {DEFAULT 0;CAFFE 1;CUDNN 2;}optional Engine engine 1 [default DEFAULT];// The axis along which t…

交叉熵和softmax

交叉熵cross-entropy loss 最大化似然函数,最小化负的似然对数函数

最终的交叉熵损失函数,最小化该loss: nn.BCELoss

def criterion(yhat, y):out -1 * torch.mean(y*torch.log(yhat) (1-y) * torch.log(1-yhat))return outsoftmax

[CS229学习笔记] 4.牛顿法,指数族分布与广义线性模型,softmax

本文对应的是吴恩达老师的CS229机器学习的第四课。这节课先介绍了牛顿法,然后给出了指数族的定义,并从指数族出发,介绍了广义线性模型并以此解释最小二乘、逻辑回归、softmax等模型的来源。 牛顿法(Newton’s Method)

牛顿法是另一种求解曲线…

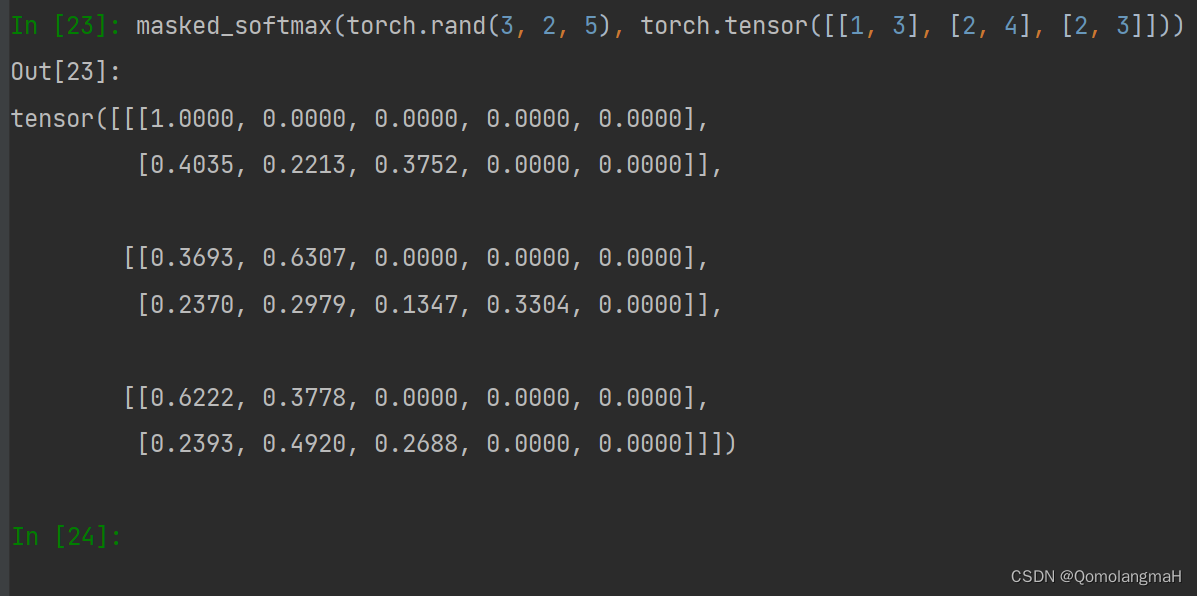

【深度学习实验】注意力机制(二):掩码Softmax 操作

文章目录 一、实验介绍二、实验环境1. 配置虚拟环境2. 库版本介绍 三、实验内容0. 理论介绍a. 认知神经学中的注意力b. 注意力机制: 1. 注意力权重矩阵可视化(矩阵热图)2. 掩码Softmax 操作a. 导入必要的库b. masked_softmaxc. 实验结果

…

Tensorflow(二)MNIST数据集分类

1.获取数据集

有两种方式可以得到数据集,第一是直接通过mnist input_data.read_data_sets(MNIST_data,one_hot True)进行联网下载,但这个方法可能很慢或者连接不到服务器,所以推荐使用第二个,在MNIST 直接下载数据,…

![计算机视觉与深度学习-全连接神经网络-激活函数- [北邮鲁鹏]](https://img-blog.csdnimg.cn/48cb48cf61fc4fae970da98a4abb667b.png)

![A.深度学习基础入门篇[四]:激活函数介绍:tanh、sigmoid、ReLU、PReLU、ELU、softplus、softmax、swish等](https://img-blog.csdnimg.cn/img_convert/15b2ac3be28f3d779b5f6ef2379ea519.png)

![深度学习与计算机视觉[CS231N] 学习笔记(3.2):Softmax Classifier(Loss Function)](https://img-blog.csdn.net/20180110190019947?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQva3N3czAyOTI3NTY=/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/SouthEast)

![[CS229学习笔记] 4.牛顿法,指数族分布与广义线性模型,softmax](https://img-blog.csdnimg.cn/20191018010319518.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzIyOTQzMzk3,size_16,color_FFFFFF,t_70#pic_center)